Das Wachstum hat Grenzen

Beim aktuellen Wachstum der KI - Marktkapitalisierung und Ressourcenverbrauch - kommen Bedenken auf, wie lange das so weiter geht.

Nach meiner Einschätzung sind viele Potentiale, sparsamer mit Ressourcen umzugehen, noch gar nicht genutzt.

Prompt-Komprimierung: 60% weniger, besseres Verständnis

Als Beispiel habe ich eine Prompt-Komprimierung entworfen, die die Länge der Prompts in meiner Anwendung um mehr als 60% reduziert.

Das Überraschende: Die KI versteht den Prompt sogar besser - bei reduzierten Kosten und Antwortzeiten.

Die Technik

- Semantische IDs: Eindeutige, bedeutungstragende Bezeichner statt verbose Beschreibungen

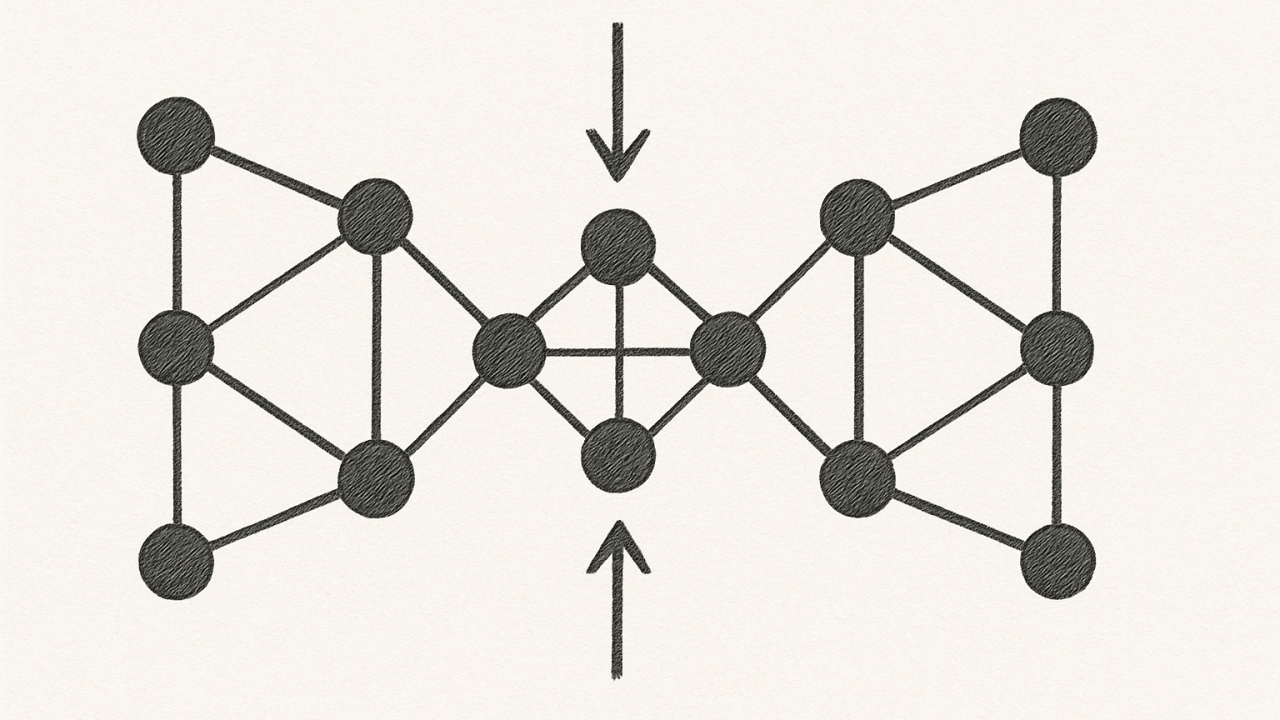

- Graph-spezifisches Format: Strukturierte Datenrepräsentation statt JSON-Overhead

Diese Kombination eliminiert Redundanz und fokussiert auf das Wesentliche - genau das, was LLMs für ihr Verständnis brauchen.

Warum funktioniert das?

Large Language Models sind darauf trainiert, Bedeutung zu extrahieren. Verbose Formulierungen und JSON-Boilerplate sind für das semantische Verständnis oft hinderlich.

Kompakte, strukturierte Formate transportieren die gleiche Information effizienter.

Fazit

Effizienz und Qualität sind kein Widerspruch. Manchmal führt weniger zu mehr:

- Weniger Token

- Besseres Verständnis

- Geringere Kosten

Bei Interesse an Details zur Implementierung: Kontaktieren Sie mich